9. Fare

Bilgisayarlarımızın neredeyse ayrılmaz parçası olan “fare” ilk olarak 1968’de San Francisco’da düzenlenen bilgisayar konferansında sahneye çıktı. Stanford Research Institute’da insan faktörleri araştırma grubunu yöneten Douglas Engelbart (1925-2013), insanların bilgisayarlarla verimli bir şekilde çalışabilmeleri için geliştirdiği yeni teknikleri kuru bir konuşma yerine canlı bir gösteriyle sunmaya karar vermişti. Önceden hazırlanmış bir terminalin başına oturdu ve mikrodalga TV bağlantısıyla 50 km uzaktaki laboratuvarında bulunan bilgisayarla bağlantı kurdu. Terminale harcıalem bir klavyenin yanı sıra, alışılmadık bir araç iliştirilmişti: Arkasından kuyruk gibi bir kablo çıkan bir kutucuk.

Engelbart, görüntüsünden dolayı “fare” adını verdikleri bu işaretleme cihazını kullanarak uzaktaki bilgisayarda basit bir kelime işlemci, basit bir hipermetin belgesi (bağlantılara tıklayarak başka belgelere ulaşma imkânı veren bir belge), ve başka etkileşimli yazılımlar çalıştırdı.

Dinleyicilerin ne kadarı farkındaydı bilinmez, ama Engelbart onlara geleceğin bilgisayarını göstermişti.

Fare deyip geçmemek gerekiyor. Fare, veya daha genel bir terimle “işaretleme cihazları”, büyük bir vizyonun, bilgisayar teknolojisinin insan zihnine eklemlenmesi tasarısının bir parçasıydı. Bu vizyonu ilk ifade eden kişi, bir psikolog olan ama ömrünü bilgisayar sanayiinin içinde geçirmiş olan Joseph Carl Robnett Licklider (1915-1990) idi.

Licklider disiplinlerarası çalışma için doğmuş biriydi. Matematik, fizik, ve psikoloji alanında üç lisans diploması alıp psikolojide yüksek lisans yaptıktan sonra uzmanlıklarını birleştirebildiği psikoakustik (seslerin algılanması) alanında doktora yaptı. 1950’de MIT’de elektrik mühendisleri için bir psikoloji programı oluşturdu. 1957’de yüksek teknoloji şirketi Bolt, Beranek & Newman’da başkan yardımcısı olarak çalışmaya başladı. 1960’da yayınladığı “İnsan-Bilgisayar Simbiyozu” başlıklı makalesinde insanların hayatlarının bilgisayarlarla içiçe geçtiği bir gelecek tasvir etti, ki o dönemdeki bilgi işleme usulü bu hayalin çok uzağındaydı.

1958’de ABD Savunma Bakanlığı’nın desteklediği DARPA (Defense Advanced Research Projects Agency – Savunma İleri Araştırma Projeleri Kurumu) tesis edildi. 1962’de Licklider DARPA’nın Bilgi İşleme Teknikleri Dairesi’nin başına geldi. İsmine rağmen DARPA doğrudan savunma projelerinden ziyade, kısa vadede uygulaması olmayan araştırmaları destekliyordu. Böylece Licklider’ın hayal ettiği şekilde bilişimi insanlarla birleştirecek araştırmalara kaynak sağlama imkânı doğdu. Engelbart’ın araştırmaları da DARPA’dan mali destek almıştı.

Fare güzel bir oyuncak olabilir, ama neden çığır açan bir buluş olsun? Elbette tek başına farenin pek faydası yoktu, ama fare bir grafik arayüzün parçasıydı, bu da radikal derecede farklı bir kullanım tarzı demekti. O zamana kadarki bilgisayar kullanımı çok üst seviyede bir soyutlama ve komut ezberleme gerektiriyordu. Oysa işaretleme cihazları, grafik arayüzlü bilgisayarların insan beyninin en kuvvetli özelliklerinden biri olan el-göz koordinasyonu ile yönetilmesini sağlıyordu. Böylece bilgisayar kullanımının insanileşmesi, kolaylaşması, kitlelere uygun hale gelmesinin kapısı aralanmıştı. Engelbart insan-bilgisayar etkileşimi denen araştırma alanına öncülük etmişti. Bugün kullandığımız grafik arayüzlerin temel prensipleri o dönemde belirlendi.

Ne var ki, Engelbart’ın sunumu kısa vadede hakettiği ilgiyi görmedi. Bilgisayar donanımı pahalıydı, yüzbinlerce dolarlık bir bilgisayarın işlem kapasitesinin bir kısmını grafik işlemleriyle harcamak makul değildi. Ancak 1970’lerde elektroniğin ucuzlaması ile işler değişti. Güçlenen ve ucuzlayan bilgisayarlarda, grafik arayüz teknolojisi sıçraması beklenmedik bir yerden, bir fotokopi makinesi üreticisinden geldi.

Xerox şirketi, yükselen Japon firmalarının rekabeti karşısında ürünlerini çeşitlendirme isteğiyle, 1969’da bilgisayar konusunda çalışacak bir ar-ge bölümü kurmuştu. Palo Alto Research Center (PARC) olarak bilinen bölümün amacı “geleceğin ofisi”ni kurmaktı. PARC’ın başına eski bir DARPA yöneticisi olan Robert Taylor (1932-) getirildi. Taylor, Licklider’la beraber çalışmıştı ve onun vizyonunu PARC’a taşıdı. Bu vizyonu Alto adı verilen bir bilgisayar sistemi üreterek somutlaştırdılar.

1973’de hazırlanan Alto çağının çok ötesinde bir bilgisayardı. Herşeyden önce, bir mainframe değil kişisel bir bilgisayardı. Bir dosya kâğıdı büyüklüğünde, dik duran ekranı grafik çıktıya uygun olarak hazırlanmıştı. Fare aracılığıyla bir grafik arayüzle çalışılıyordu. Alto’lar birbirlerine Ethernet standardı kullanan bir ağla bağlanabiliyorlardı. Alto’ları lazer yazıcılarla kullanmak da mümkündü.

Yaklaşık bin adet Alto üretildi, fakat bunlar satışa sürülmeyip Xerox içinde kullanıldılar. Henüz kişisel bilgisayar devrimine birkaç yıl vardı, ve çoğu insan koca bir bilgisayarın tek kişinin kullanımına adanmasını abes buluyordu. Zaten maliyeti 18 000 doları bulan bir kişisel bilgisayarın alıcı bulması çok zordu. Kişisel bilgisayar pazarının açılmasından sonra 1981’de ticari bir model hazırlandı ve Xerox Star adıyla piyasaya sürüldü. Ancak, çok üstün teknik özelliklerine rağmen çok yüksek fiyatı ve şirketin pazarlama başarısızlığı yüzünden piyasada tutunamadı.

Yine de Alto bilgisayar tarihini dolaylı yoldan etkiledi. 1979’da Steve Jobs PARC’ı ziyaret ettiğinde Alto’yu inceledi ve hayran kaldı. Fare ve grafik arayüz kullanımının bilgisayarların yaygınlaşmasının anahtarı olacağını tahmin etti ve yeni Apple modellerinin tasarımını buna göre yönlendirdi. Lisa adlı başarısız bir modelden sonra 1984’de ünlü Macintosh piyasaya çıktı. PC dünyasında aynı gelişme birkaç yıl sonra Microsoft’un Windows yazılımı ile sağlandı.

Fare çoğu insanı yıldıran siyah komut ekranını ortadan kaldırdı ve daha çok kullanıcının bilgisayara ısınmasına vesile oldu. Grafik arayüz görsel ve daha anlaşılır bir çalışma ortamı sağladı. Zamanla fareler gelişti, kolay bozulan toplu fareler yerine dayanıklı ve hassas optik fareler gelişti. Sürükleme topu (trackball) ve dizüstü bilgisayarlardaki touchpad gibi alternatif işaret cihazları icat edildi. Artık akıllı telefon ve tabletler ile sadece dokunmatik ekranlarıyla, yani işaretleme ile etkileşim kuruyoruz. Masaüstü bilgisayarların yakında yerlerini mobil cihazlara bırakacağı söyleniyor. Yakında bilgisayarlarla bilimkurgu filmlerindeki gibi boşlukta el hareketleri ile etkileşmeye başlayabiliriz. Bütün bunlar 45 yıl önce Douglas Engelbart’ın elindeki gösterişsiz tahta kutunun içinden çıktı.

10. Web 2.0

Son maddeye başlamadan önce bir durup, çığır açıcı bulma kriterlerimizi gözden geçirelim.

Başka icatları yaratan bir kök icat, çığır açıcı olarak düşünülebilir. “Y olmasa Z olmazdı, X olmasa da Y olmazdı” mantık zinciriyle gidebildiğimiz kadar geriye giderek bir alandaki en önemli icadı bulabiliriz. Ama bunda iki sorun var. Birincisi, icatlar genellikle birden fazla kaynaktan beslenirler, doğrusal bir çizgi takip etmezler, hatta bazen birbirlerini aynı anda geliştirirler. İkincisi de, hiç bir icat gökten inmediği için, bu zincirin sonunda nihai çığır açıcı icat olarak “ateş yakma”ya varırız. Bu kadar geriye gitmek de abes olur elbet.

Bu listedeki icatları seçerken mihenk taşım şu oldu: Daha önceki teknolojilerden ciddi şekilde farklı olan inovasyonlar (meselâ transistörler), veya varolan teknolojileri biraraya getiren, büyük bir inovasyon içermeyen, ama öngörülemeyen büyük sonuçlar yaratanlar (meselâ kişisel bilgisayarlar).

Büyük bir sonuç olarak önümüzde bilgisayar ağları var. Hayatımızın her alanına entegre olmuş durumda. Peki, “ağ toplumu”nun çığır açıcı adımı nerede atıldı?

Teknoloji olarak bakıldığında bu adımın, yukarıda bahsettiğim DARPA kurumunun fonlarıyla desteklenen ARPANET projesi ile atıldığı söylenebilir. 1960’ların başında tasarlanmaya başlayan ve 1970’de devreye giren ARPANET’in amacı, coğrafi olarak birbirinden uzak mainframe bilgisayarları iletişim hatlarıyla birbirine bağlamaktı. Bu sayede bir bilgisayarın yoğun olduğu durumlarda iş yükünü başka bir bilgisayara aktarmak, böylece kaynakların daha ekonomik kullanılmasını sağlamak amaçlanıyordu.

ARPANET’i oluşturmak kolay olmadı. O dönemin birbirinden çok farklı iç yapıya sahip ve değişik veri kodlama usülleri olan bilgisayarlarının kullanabileceği güvenilir bir platform yaratmak gerekiyordu. Bu amaçla, verilerin parçalara bölünüp ağ üzerinden gönderilmesi, kaynaktan hedefe doğrudan bağlantı yoksa aradaki bilgisayarların veriyi yönlendirmesi gibi yöntemler geliştirildi. Ağdaki bilgisayarların iletişim kurma kurallarını belirleyen “protokol”ler, TCP (Transmission Control Protocol – İletim Yönetimi Protokolü) ve IP (Internet Protocol – Ağlar arası protokol), yine ARPANET himayesinde gelişti. Bugünkü internet altyapısı hâlâ bu teknolojilerin üzerinde durduğu için ARPANET’in çığır açıcı olduğu söylenebilir.

Başka bir açıdan bakıldığında ise asıl büyük adımın Ethernet teknolojisi olduğu söylenebilir. Bu teknoloji 1973’de, Xerox PARC’da Alto bilgisayarı ile beraber geliştirildi. Buradaki amaç yerel olarak bağlı bilgisayarların bilgi alışverişi yapmasını sağlamaktı. Bir ofiste veya laboratuvardaki bilgisayarlar ortak bir aktarım kablosuna bağlanır, ve her biri diğerine sinyalleri aynı hat üzerinden gönderir. Sinyallerin karışmasını engellemek için, bir odadaki sohbette insanların kullandığı nezaket protokolüne benzer kurallar uygulanır. Sözgelişi, her bilgisayar iletişimi dinler, kanal boşsa kendi sinyalini gönderir. İki bilgisayar aynı anda sinyal gönderdiyse ikisi de durur, rastgele bir süre sonra tekrar denerler.

ARPANET birbirinden uzak ana bilgisayarlar arasında çalışan bir iletişim omurgasıydı, Ethernet ise yakın mekândaki kişisel bilgisayarları bağlayan bir yerel ağ oluşturuyordu. Birbirini tamamlayan bu iki teknoloji 1970’lerde ortak protokollerde birleşti ve bu protokoller bugüne kadar geldi. Bu yazıyı okuduğunuz bilgisayar Ethernet kurallarına göre çalışan bir devreyle ağınızın “router”ına bağlandı, o da TCP/IP kurallarıyla Açık Bilim sunucusundan bu sayfayı talep etti, ve sizin bilgisayarınıza aktardı.

Ancak, fiziksel bir ağ yapısı o kadar da orijinal bir fikir değildi. İletişim ağı olarak telefon şebekesi örneği vardı. Hatta önceki yüzyılda geliştirilen telgraf şebekesi bile “Victoria devri interneti” olarak anılmayı hakedecek derecede yoğun bir bilgi aktarımı sağlamıştı. Bu yüzden, biraz da cüretkâr davranarak, çığır açıcı olan gelişmenin bağlantı kurabilmek değil, aktarılan bilgilerin anlamlı şekilde organize edilmesi olduğunu savunacağım.

1980’lerde, varolan internet altyapısı üzerinde çeşitli bilgi alışverişi yöntemleri gelişti. Dosya paylaşımı, e-posta, ilan tahtası sistemleri (BBSler), listserv haberleşme grupları gibi. Bunlar küçük meraklı gruplarına hitap ediyordu, geniş kitlelere yayılmamıştı (kişisel bilgisayarların ilk aşamalarının da böyle olduğunu geçen ayki yazıdan hatırlarsınız).

World Wide Web beklenmedik bir yerden çıkageldi. 1990’da, İsviçre’deki uluslararası yüksek enerji fiziği laboratuarı CERN’de çalışan İngiliz fizikçi ve yazılım mühendisi Tim Berners-Lee (1955-), değişik bilgisayarlara dağılmış verilerin, hipermetin tıklamalarıyla birleştirilebileceği bir belge sistemi tasarladı ve Belçikalı yazılım uzmanı Robert Cailliau (1947-) ile işbirliği yaparak geliştirdi. Her Web adresinin başında gördüğünüz http (HyperText Transfer Protocol – Hipermetin Aktarma Protokolü) ve web sayfalarının görüntülenmesi için kullanılan kodlama dili HTML (Hypertext Markup Language – Hipermetin İşaretleme Dili), Berners-Lee tarafından icat edildi.

WWW kısa zamanda CERN sınırlarını aştı ve dünya çapında bir bilgi paylaşımı sistemi haline geldi. Berners-Lee’nin 1991’de yaptığı bir konferans sunumundan sonraki iki yıl içinde Web standardıyla hazırlanmış belgelerin sayısı hızla arttı. Berners-Lee Web yapısının ticari sır haline getirilmemesi, herkese açık bir geliştirme platformu olmasını istiyordu; CERN’i Web teknolojisini halka açmaya ikna etti.

İlk yıllarda Web sayfalarına metin temelli tarayıcılarla (örneğin Lynx) erişiliyordu. 1990’ların ortalarında iki gelişme Web’in akademik çevrelerden topluma hayata yayılmasını sağladı. Birincisi, 1994 sonunda hazırlanan grafik arayüzlü Netscape tarayıcısıydı. Netscape ile Web sayfalarında resim, müzik ve video gösterilebiliyor, sayfa düzeni şık bir şekilde düzenlenebiliyordu.

İkinci önemli gelişme Web’in ticarileşmesiydi. ARPANET ve 1990’da onun yerine geçen NSFNET internet omurgalarının masrafları ABD hükümeti tarafından karşılandığı için ticari amaçla kullanılmaları yasaktı. 1995’de NSFNET kapatıldı, yerini o zamana kadar serpilmiş özel internet servis sağlayıcıları aldı. Böylece mal ve hizmet satan kâr amaçlı Web siteleri kurulabildi ve e-ticaret hacmi hızla arttı. Ticarileşmeyle beraber Web sayfalarının profesyonelliği arttı, programcılar gitgide daha güzel görünen sayfalar hazırlamayı, ve karmaşık bilgilerin organize edilebildiği site düzenleri kurmayı öğrendiler.

Web’in ani patlamasının hikâyesini hepimiz biliyoruz. Ne oldu demeye kalmadan Web, banka işlemlerimiz, alışverişimiz, haberleşmemiz ve sosyalleşmemizde merkezi duruma geldi.

O zaman, Tim Berners-Lee’nin aklının ürünü olan WWW’nin çığır açıcı olduğunu söylemek doğru olur. Bununla beraber, 2000’lere gelene kadarki Web ile, son on yılın Web’i arasında büyük farklar olduğu da iddia edilebilir.

2000’lerin başında Web sayfalarının altyapısında olmasa da, görünüşü ve kullanılışında radikal bir değişiklik yaşandı. Eskinin statik (her açılışta aynı kalan, yeni içeriğin ancak sayfa tasarımcısı tarafından eklenmesiyle görülebilen, zayıf etkileşimli) Web sayfalarının yerini dinamik sayfalar aldı. Bu siteler kullanıcıya özel şekilde oluşturulabiliyor, anlık değişiklikleri gösterebiliyor, içinde başka uygulamaları barındırabiliyordu. Bu yeni yaklaşıma, yazılım sürümlerinin numaralanmasından ilham alarak, Web 2.0 adı yakıştırıldı.

Web 2.0 kavramı teknolojik altyapıda fazla bir değişiklik içermez. Bitler ağ üzerinde kırk yıllık TCP/IP protokolüyle aktarılır, web uygulamaları HTTP protokolüyle açılır, sayfalar HTML sayfalarıyla görüntülenir ve 1990’larda kullanılan aynı programlama dilleriyle programlanır. Asıl önemli fark, bu sayfaların sunduğu hizmetlerdedir.

1990’ların Web’i (“Web 1.0”) çok önemli bir devrim yapmış, isteyen herkesin kendi web sayfasını oluşturabileceği araçlar sunmuştu. Yine de bu araçlar belli bir teknik zorluğa göğüs germeyi gerektiriyordu, sayfayı barındıracak bir internet hizmeti (“hosting”) ve alan ismi satın almak, HTML kodlaması yapmak gibi. Bireylerin söz hakkı bir miktar artmıştı, ama ifadenin önündeki bariyerler tamamen kalkmamıştı.

Web 2.0 ise kişiler arası bağlantıları, iletişimi, ortak çalışmayı, içerik üretimini ön planda tutar. Sözgelişi, Web programlama zahmetine girmek istemeyenler ücretsiz olarak, hazır kalıpların bulunduğu Web alanları oluşturabilirler. Bunlar statik sayfalar da olabilir, bloglar gibi belli usullerde dinamik hizmet veren siteler de. “İçerik yönetim sistemleri” denen üst düzey Web programlama araçları, tam teşekküllü bir site oluşturmayı çok kolay hale getirerek site sahibinin, yazacağı içeriğe odaklanmasını sağlıyor.

Örnek vermek gerekirse, son yılların belki de en büyük uygarlık adımı olan Wikipedia “wiki” adı verilen özel bir içerik yönetim sistemi kullanır. Ama ne okuyucuların, ne de madde yazarlarının bunun ayrıntısını bilmesi gerekmez. Bazı basit kuralları kullanarak içerik yaratmak esastır. Wikiler ve benzeri internet imecelerinin (“crowdsourcing”) devrimsel yanını anlatmak buraya sığmaz. Web 2.0’ın sağladığı araçların temel yararını Clay Shirky’nin ifadesiyle şöyle özetleyebiliriz: “Bir örgüt olmanın minimum maliyeti nispeten yüksek olduğu için, bazı faaliyetler, belli değerleri olsa da, örgütlü şekilde yürütülmeye değecek kadar değerli değildirler. Yeni sosyal araçlar, grup eylemini koordine etmenin maliyetini düşürerek bu denklemi değiştirir.”

Sosyal ağlar, Facebook, Twitter, FriendFeed, LinkedIn, Google+, ve daha niceleri, Web 2.0 kapsamındaki araçlar ve kavramlar ile ortaya çıktı. Bunlar bireylere hızlı ve ücretsiz olarak içerik üretme imkânı vermekle kalmadı, paylaşma ve tartışma ortamı da doğurdu. İfade bariyerleri daha da aşağı indi.

Sosyal ağlar toplumsal ve siyasi değişimde de kilit rol oynuyor. Eskiden kolayca örtbas edilen kabahatler sosyal medyada fırtına gibi esiyor, hafızalara yerleşiyor. İletişimin kolaylaşmasıyla örgütlenme imkânı artıyor, Arap Baharı veya Gezi Direnişi gibi kitle hareketleri bir anda ortaya çıkıveriyor.

Coursera, EdX, KhanAcademy gibi sitelerin sunduğu çevrimiçi dersler, geleneksel eğitimi ortadan kaldırmasa bile, muhtemelen değişik bir biçime sokacak. Yeni Web araçları bilimsel araştırmaya da damgasını vuruyor; eski yayıncılık modeli değişiyor, makalelerin “müsvedde”lerini barındıran arşivler en çok kullanılan yayın mecraı haline geldi. Bilimsel araştırmanın her aşamasının paylaşılmasından bahsediliyor.

Web 2.0, bilgiye bakışımızı kökten değiştirdi. Eski medyada gazeteler, basılı ansiklopediler, televizyonlar, tek yönlü ve tartışmasız bir otorite oluştururlardı. Yeni medya ise bunların çoğunun üzerinden atlayıp geçiyor. Tek taraflı değil, kişilerin karşılıklı tartışmaları ve paylaşmalarından ortaya çıkan yeni bir resim çiziyor. Bu yeni tavır, eskiye alışık olanların tepkisini çekiyor. Sosyal ağlarda yayılan yalan haberleri ve abartıları kötü örnek olarak göstermek yaygın, fakat buna karşılık geleneksel medyada da yalanlar ve çarpıtmaların çok sayıda olduğunu gördük, özellikle de Gezi direnişi ve daha sonraki olaylarda. Web 2.0 araçlarını kullandıkça görüyoruz ki, kitlesel katılımla hazırlanan içerikte, Wikipedia sayfası olsun, twitter haberleri olsun, gerçeğin daha kapsamlı ve doğru bir ifadesine ulaşmak mümkün.

Toplum hayatında devrim yaratan kişisel bilgisayarların bir teknolojik atılımdan çok, varolan teknolojinin farklı bir kullanım tarzı olduğunu görmüştük. Aynı şekilde Web 2.0 da, mevcut yazılım ve donanım sistemlerinin kitlesel kullanıma uygun hale getirilmiş paketlemelerinden başka birşey olmasa da, hayatımızda olağanüstü değişiklikler yaptı ve yapmaya devam ediyor.

11. İkili sistem

“Dünyada 10 çeşit insan vardır: İkili sistemi bilenler ve bilmeyenler.” – Anonim

Buraya kadar, aşağı yukarı kronolojik sırayla, on değişik çığır açıcı teknoloji gördük. Bunların bir kısmı diğerlerine temel oldu, bir kısmı varolanların değişik bir bakış açısıyla kullanılması ile gerçekleşti.

Ancak açıkça görünür olmasa da bütün bilgisayar teknolojisinin altında yatan bir teorik kavram var: Bilgiyi ikili sistemde, sıfırlar ve birler dizisi olarak kodlamak ve işlemek. Bilişim teknolojisi tamamıyla bu matematiksel teorinin görünmez temeli üzerinde durur.

İkili sistemde yazılan her işaret bir bit (“binary digit” – ikili rakam) olarak anılır ve sadece 0 veya 1 değerlerini alır. 1950’lerden bu yana bütün bilgisayarlar ve diğer dijital araçlar bilgiyi bitler dizisi olarak saklar, kullanır ve aktarır. Ancak eski bilgisayar tasarımlarının hepsi ikili sistem kullanmıyordu. Howard Aiken’in Harvard Mark I cihazı (1943), hatta daha sonraki ENIAC (1946) bile sayıları onlu tabanda saklıyor ve işliyordu. Daha öngörülü tasarımlar olan Konrad Zuse’nin mekanik Z1 (1937) makinesi ile, John Atanasoff ve Clifford Berry’nin lambalı ABC’si (1942) ikili tabanda çalışıyorlardı.

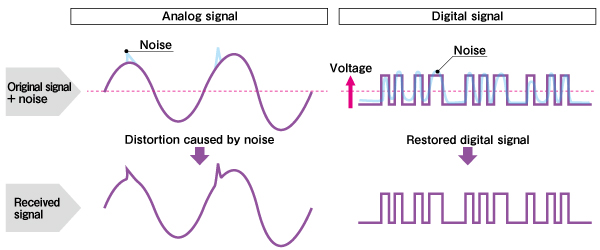

Bitler ve ikili sistem neden bu kadar önemli? Biri teknik, biri matematiksel olmak üzere iki sebebi var. Teknik sebep, ikili sistemde kodlanmış verilerdeki aktarımındaki hataların ortadan kaldırılabilmesinin kolay olması. Sözgelişi, antenle dinlediğimiz radyo ile, Açık Bilim’in cepyayınını karşılaştıralım. Birincisi radyo vericisinden aktarılan analog sinyallerle bize ulaşır. Radyoda ses, radyo dalgasının frekansının an be an küçük miktarlarda değiştirilmesiyle kodlanır. Ancak etrafımızı saran başka elektromanyetik dalgalar da vardır: Başka radyo kanalları, TV veya telsiz yayınları, cep telefonu sinyalleri, az da olsa evimizdeki ampullerden çıkan radyo dalgaları, hatta şimşekler. Bu dalgaların bazıları alıcımızda sinyale karışır ve sinyali az da olsa değiştirir. Radyodaki “parazit”in sebebi budur. Antenli televizyonlarda aynı etki kumlu görüntü olarak kendini belli eder.

Açık Bilim’in cepyayınındaki ses ise ikili sistemde kodlanmıştır. Bu kodlamada ses dalgasından sık aralıklarla “numune” alınır, ve her numunedeki dalga büyüklüğü ikili sistemde (genellikle çok sayıda bitle) ifade edilen bir sayıya dönüştürülür. Bunlar arka arkaya eklemlenerek dijital ses dosyasını oluştururlar (genellikle de dosya boyunun küçülmesi için sıkıştırma uygulanır).

Dijital bilgi aktarılırken de elbette yukarıda saydığım elektromanyetik parazit yine sinyale eklenir. Ancak, genellikle parazit dijital sinyalin 0 ve 1’lerini ayıran aralıktan daha zayıftır. Dijital alıcı belli bir eşiğe kadar olan dalgalanmaları düzeltebilir, meselâ 0.7 değerini 1 olarak, 0.2 değerini 0 olarak alır. Bu yüzden parazit, çok kuvvetli olmadıkça, dijital sinyali bozmaz.

Aynı avantaj kopyalamada da geçerlidir. Analog kayıt yapan eski tip bir manyetik teyp kasetini başka bir kasete kopyaladığınızda az da olsa bazı sesleri kaybedersiniz. Kopyanın kopyasını yaparsanız biraz daha bilgi kaybedersiniz. Dijital kopyalamada ise, hem dijital sinyalin ayrıklığından, hem de çeşitli hata düzeltme algoritmaları kullanıldığından, bilgi kaybı yok denecek kadar azdır.

Teknik avantajının yanı sıra ikili sistem, dijital devrelerin temel matematik ile tasarlanıp analiz edilmesine de elverişlidir. Bitler 1-0 yerine bazen doğru-yanlış veya evet-hayır şeklinde de yorumlanırlar. Bu onları, temel önermeler mantığına bağlar. Önermeler de bitler gibi iki değerlidir, ya doğrudurlar ya yanlış, üçüncü bir şık yoktur. Önermelere ve, veya, değil gibi işlemler uygulanarak yeni önermeler üretilebilir. Karmaşık mantık işlemleri, Boole cebrinden türetilen bazı bağıntılarla basitleştirilebilir.

Bu matematiksel/mantıksal kavramlar dijital elektroniğe birebir aktarılabilir. İkili veriler, bunlarla ve, veya, değil işlemi yapan elektronik devrelere (mantık kapıları) bağlanır. Mantık kapıları ise birleştirilerek aritmetik, bellek erişimi, veri saklama gibi işlemler yapan devrelere dönüştürülebilir. Bunların hepsinin işleyişi Boole cebri ile analiz edilebilir. Dahası, devre tasarımı ve analizi bu matematiksel araçlar yardımıyla otomatik hale getirilebilir, yani devre tasarımı yapan programlar üretilebilir.

Bugünkü bilgisayar devrimimizin kökü temel matematikten beslenir. Eğer verileri ikili sistemle kodlamasaydık elektronik parazit gibi teknik bir sorunu aşmamız belki yine mümkün olurdu, ama devreleri temel mantık ve Boole cebri kullanarak analiz etmemiz mümkün olmayacaktı ve muhtemelen elektronik devreleri bugünkü karmaşıklığına ulaştıramayacaktık.

Bence bu, temel bilimlerle sağlanan bilgi birikimi olmadan teknolojik gelişmenin mümkün olmayacağını ispatlayan en güzel örneklerden biri.

Kaynaklar

- Paul E. Ceruzzi, A History of Modern Computing, 2nd ed., MIT Press, 2003.

- Martin Campbell-Kelly, William Aspray. Computer: A History of the Information Machine, 2nd ed., Westview Press, 2004.

- Michael R. Williams, A History of Computing Technology, 2nd ed., IEEE Computer Society Press, 1997.

- Clay Shirky, Herkes Örgüt, çev. Pınar Şiraz, Optimist, 2010.

- Yamaha Corp., The Merits of Digital Sound.

- Minority Report, yön. Steven Spielberg, 20th Century Fox, 2002.

- Richard T. Griffiths, History of the Internet Chapter Two: From ARPANET to World Wide Web.

Cok tesekkur ederim. Cok guzel bir yazi serisi olmus.

Dört bölümde başarılı, ancak mikroişlemcilerden ve ikili sistemden bahsedip, Claude Elwood Shannon’dan hiç bahsedilmemesi önemli bir eksik